KoboldCpp est un logiciel open source de génération de texte et d'images par IA qui utilise des modèles LLM au format GGML et GGUF que vous avez choisi et téléchargé sur votre ordinateur. Il est doté d'une interface utilisateur graphique (GUI) conviviale qui facilite son utilisation, même pour les utilisateurs novices en IA.

Avec KoboldCpp, vous pouvez réaliser des tâches que réalisent traditionnellement n'importe quel chatbot d'IA mais ce logiciel est surtout développé pour le jeu de rôle. En effet, il est possible d'importer des scénarios, des personnages fictifs avec un caractère pré-établi ou encore de paramétrer le logiciel afin de contrôler l'IA plus précisément pour un jeu de rôle parfait.

Kobold Lite dispose de 4 modes de génération de texte :

- Mode Histoire : Pour la fiction créative et l'écriture de romans, l'IA continue votre histoire en se basant sur vos données.

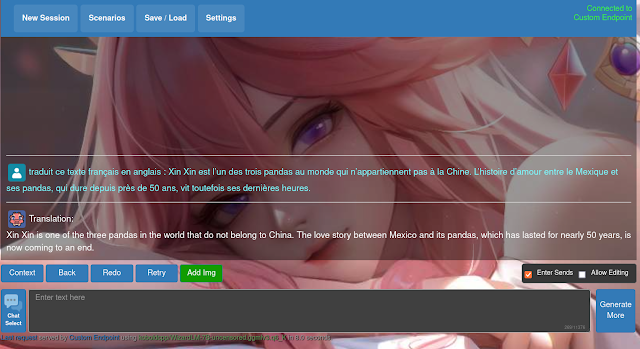

- Mode Chat : Simule un personnage avec un chatbot d'IA interactif. Demandez à l'IA n'importe quoi ou discutez avec elle dans le cadre d'une conversation à tour de rôle.

- Mode instruction : Mode d'instruction-réponse de type ChatGPT.

- Mode Aventure : Fiction interactive de type AIDungeon, décrivez une action et l'IA génèrera du texte en fonction. Vous pouvez importer un scénario pré-créé, que vous pouvez sélectionner à partir du menu « Scénarios ».

Pour Windows l'utilisation s'effectue via un fichier exe a télécharger sur le github.

Pour linux, voici comment faire :

1. Installation sur linux (ubuntu/mint) :

Ouvrez votre terminal et collez :

curl -fLo koboldcpp https://github.com/LostRuins/koboldcpp/releases/latest/download/koboldcpp-linux-x64-cuda1150 && chmod +x koboldcpp

Cette commande a téléchargé et rendu exécutable koboldcpp. Vous trouverez l'application dans votre dossier personnel (Poste de travail/Dossier Personnel) où vous pourrez la démarrer par un double clic ou en ouvrant votre terminal avec la commande suivante : ./koboldcpp

edit du 11/08 :

Télécharger les dernières versions de koboldccp ici. Prendre version cuda1210 pour linux mint 22. Rendez exécutable le fichier et double cliquer dessus pour démarrer l'application.

2. Choisir et télécharger un modèle :

Pour choisir et télécharger un modèle consultez ce sujet.

3.Démarrer un modèle :

(1) Cliquez sur Browse.

(2) Sélectionnez votre modèle.

(3) Cliquez sur ouvrir.

(4) Cliquez sur Launch.

Patientez pendant le chargement.

Une fenêtre s'ouvre dans votre navigateur. En cas de message d'erreur (La connexion a échoué), rechargez la page.

4. Explications des options du launcher :

Quick launch :

En général, vous n'avez pas besoin de changer grand-chose à part les préréglages et les couches de GPU.

(1) Presets :

- CuBLAS : Uniquement pour les GPU Nvidia. Nécessite CUDA.

- CLblast : Pour la plupart des GPU, y compris les iGPU de Nvidia, AMD et Intel. Nécessite l'installation de la bibliothèque CLBlast.

- OpenBLAS : CPU uniquement.Nécessite l'installation de la bibliothèque OpenBLAS

(2) GPU ID : Le multi-GPU n'est disponible que lors de l'utilisation de CuBLAS.

(3) Disable MMAP : mmap, ou memory-mapped file I/O, permet de mapper des fichiers ou des périphériques dans la mémoire. Il s'agit d'une méthode permettant de réduire la quantité de mémoire vive nécessaire au chargement du modèle, car les éléments peuvent être lus du disque vers la mémoire vive à la demande.

Si le modèle LLM est utilisé pour des tâches en temps réel à faible latence, la désactivation de MMAP peut être préférable pour minimiser les retards.

Si le modèle LLM est utilisé pour des tâches moins sensibles à la latence, MMAP peut être acceptable, voire bénéfique pour réduire l'utilisation de la mémoire vive.

En conclusion, la décision de désactiver ou non MMAP pour un modèle LLM dans un logiciel dépend de divers facteurs et nécessite une analyse minutieuse de votre cas d'utilisation spécifique et de la configuration matérielle.

(4) Context Size : quantité de texte ou de données que le modèle prend en compte lors du traitement d'une entrée.

Une taille de contexte plus importante peut généralement conduire à une meilleure précision, car le modèle dispose de plus d'informations pour contextualiser l'entrée mais augmente le temps de traitement.

Pour les tâches nécessitant une grande précision, comme la traduction automatique ou la génération de texte créatif, une taille de contexte plus importante peut être bénéfique. Pour les tâches nécessitant une faible latence, comme la complétion de phrases ou la réponse à des questions, une taille de contexte plus petite peut être préférable.

KoboldCpp supporte un context size jusqu'à 16k pour les modèles GGML et 32k pour les modèles GGUF.

Enable flash attention (nouveau dans version 1.67) : algorithme d'attention prometteur qui peut aider à améliorer les performances des modèles basés sur le transformateur. Il est particulièrement utile pour les modèles de grande taille qui traitent de longues séquences.

Paramètres Hardware :

High Priority : augmente les ressources allouées à KoboldCpp. Il n'est pas recommandé d'activé ce paramètre (risques de lags).

Use mlock : technique utilisée pour forcer un modèle à rester dans la mémoire vive après son chargement. Sur certains systèmes, en particulier lorsque la mémoire vive est rare, le système d'exploitation peut déclencher un échange de mémoire trop fréquemment, ce qui réduit les performances. L'utilisation de mlock permet d'éviter cela. mlock est désactivé par défaut.

Tokens :

Customs RoPE config : permet d'augmenter la quantité d'information qu'un modèle LLM peut prendre en compte lors d'une conversation afin de mieux comprendre la discussion.

- Rope Scale : Plus vous augmentez la valeur, plus le contexte est grand, mais la compréhension pourrait en pâtir un peu.

- Rope Base (NTK-Aware) : étend le contexte utile des modèles existants sans nécessiter un réentraînement complet.

Model Files :

LoRA (Low-Rank Adapter) / LoRA Base : LoRA : technique pour affiner efficacement les grands modèles de langage (LLM). Elle fonctionne en ajoutant un ensemble de poids plus petit (adaptateur) à un modèle existant au lieu de modifier directement tous les poids d'origine. Cela rend le processus plus rapide et nécessite moins de mémoire que le fine-tuning traditionnel.

LoRA offre un moyen efficace d'affiner les LLM. Il est recommandé de fusionner le LoRA avec le modèle de base avant la conversion pour une qualité optimale avant de convertir le résultat final au format GGUF.

LLaVA : un modèle multimodal de grande taille (LLM) entraîné a traiter et comprendre à la fois du texte et des images.

mmproj : permet de charger un "projecteur multimodal" sur un modèle LLM. Un projecteur multimodal est un ensemble d'outils permettant à un LLM de traiter des informations issues de sources différentes, comme du texte et des images.

En résumé, avec mmproj, vous pouvez transformer un LLM standard en un LLM multi modal. Cela signifie que le LLM pourra alors comprendre et réagir non seulement au texte que vous lui donnez, mais aussi aux images que vous lui envoyez.

Horde Worker : plateforme qui permet aux utilisateurs de partager leur puissance de calcul inutilisée pour générer des images et du texte pour d'autres utilisateurs. Cela fonctionne comme un réseau distribué, où chaque utilisateur contribue une petite quantité de ressources pour alimenter le système global.

Les utilisateurs finaux peuvent aller sur https://lite.koboldai.net/ pour générer du texte et des images.

Image Gen : génération d'images en local, grâce à stable-diffusion.cpp. Il suffit de sélectionner un fichier SD1.5 ou SDXL compatible.

5. Explication des paramètres de l'application :

A/ Paramètres Basic :

|

Température : contrôle le caractère « aléatoire » de la sortie en échelonnant les probabilités sans supprimer d'options. Les valeurs inférieures sont plus logiques, mais moins créatives.

Max Ctx. Tokens : nombre maximum de tokens qui seront envoyés à l'IA. Un token est une unité de base utilisée par l'IA pour représenter du texte, similaire à un mot.

Amount to Generate : permet de définir la longueur maximale de la réponse que l'IA va générer pour traiter votre requête.

Top p Sampling : équilibre la créativité et la cohérence du texte généré par l'IA. Une valeur de P trop faible rend le texte prévisible, alors qu'une valeur trop élevée peut conduire à des phrases incohérentes.

Repetition Penalty : encourage l'IA à utiliser un vocabulaire plus riche et à produire un texte plus fluide et naturel. Une valeur plus élevée de la pénalité peut parfois conduire à des phrases moins coulantes si l'IA n'arrive pas à trouver de bons synonymes. Il est donc important d'ajuster cette valeur en fonction de vos besoins et du type de texte que vous souhaitez générer.

Format : Le mode Histoire est plus adapté à l'écriture de romans. Le mode Aventure est idéal pour les jeux de fiction interactifs. Le mode Chat est idéal pour les conversations avec l'IA. Le mode Instruction permet de confier à l'IA des tâches de type ChatGPT.

Instruct Tag Preset : outil pratique qui facilite la communication avec l'IA lors de la génération de texte. Il vous permet de définir facilement le style et le format de votre texte en sélectionnant un instruct tag préconfiguré adapté au modèle d'IA que vous utilisez.

UI Style Select : changement interface utilisateur.

Sys. Prompt : instruction fournie au système d'IA au tout début du processus de génération. Elle sert à orienter le comportement de l'IA de manière générale. La plupart du temps, vous n'aurez pas besoin d'utiliser un Sys. Prompt. L'IA peut générer du texte cohérent en se basant uniquement sur votre demande principale.

Dans des situations spécifiques, un Sys. Prompt peut être utile pour :

Fournir des informations contextuelles supplémentaires qui ne font pas directement partie de votre demande ou ajuster le style général du texte (par exemple, plus formel, plus créatif, etc.).

Start Seq. et End Seq : sont deux options que vous pouvez utiliser lors de la génération de texte par IA pour définir clairement le début et la fin de vos instructions. Elles permettent de mieux structurer vos requêtes, ce qui peut aider l'IA à mieux les comprendre et à générer un texte plus précis.

Séquence de caractères que vous placez au début ou la fin de votre instruction pour indiquer à l'IA qu'il s'agit d'une instruction. Vous pouvez choisir une séquence simple comme "##" ou une séquence plus descriptive comme "## Instruction :".

exemple :

## Instruction : Écrire un poème sur l'amour.

Le cœur battant, l'âme enflammée,

Par tes yeux bleus je suis charmé.

Tes paroles douces, comme une mélodie,

Font vibrer mon être, ma poésie.

## Fin

Enable Markdown : option permettant de formater le texte généré par l'IA lors de la création d'instructions. En l'activant, vous autorisez l'IA à générer des instructions formatées avec du Markdown, ce qui permet d'inclure facilement des éléments comme des listes de tâches, des tableaux de données et des blocs de code. Ceci rend vos instructions plus claires, plus organisées et plus faciles à suivre.

Inject Timestamps : option permettant d'inclure des repères temporels dans le contexte fourni à l'IA pour la génération de texte. En incluant des horodatages, vous permettez à l'IA d'avoir une meilleure compréhension de la chronologie des événements décrits dans votre contexte. Cela peut l'aider à générer du texte plus cohérent et plus logique, en tenant compte de l'ordre temporel des actions ou des informations.

Si vous demandez à l'IA d'écrire une histoire sur un voyage en train, le fait d'inclure des horodatages ("Lundi 10h : Départ du train", "Mardi 14h : Arrivée à la gare") l'aidera à construire une chronologie logique des événements se déroulant pendant le voyage.

- Top-K : Cette option sélectionne les K phrases les plus probables générées par le modèle de langage comme sorties potentielles. K est un nombre entier positif que vous pouvez définir. Plus la valeur de K est élevée, plus la diversité des sorties sera grande, mais plus le processus de génération sera lent.

- Top-A : Cette option sélectionne les phrases dont la probabilité cumulée est supérieure ou égale à un certain seuil A, compris entre 0 et 1. A contrôle la balance entre la diversité et la qualité des sorties. Des valeurs de A plus élevées conduisent à des sorties plus probables et plus cohérentes, mais moins variées.

- Typ. TFS : Cette option utilise une technique appelée "temperature sampling" pour générer des sorties. La température contrôle la diversité des sorties. Des valeurs de température plus élevées conduisent à des sorties plus originales et surprenantes, mais moins probables et cohérentes. Des valeurs de température plus basses conduisent à des sorties plus probables et cohérentes, mais moins variées.

Quel choix utiliser ?

Le choix du paramètre à utiliser dépend de vos besoins spécifiques. Si vous recherchez une grande diversité de sorties, même si elles sont moins probables et cohérentes, vous pouvez utiliser Top-K avec une valeur de K élevée. Si vous recherchez des sorties plus probables et cohérentes, vous pouvez utiliser Top-A avec une valeur de A élevée. Si vous recherchez un équilibre entre la diversité et la qualité des sorties, vous pouvez utiliser Top-K avec une valeur de K modérée ou Top-A avec une valeur de A modérée. Si vous souhaitez des sorties originales et surprenantes, vous pouvez utiliser Typ. TFS avec une valeur de température élevée. Si vous souhaitez des sorties plus probables et cohérentes, vous pouvez utiliser Typ. TFS avec une valeur de température basse.

- Seed : Cette option permet de définir une valeur de départ pour le modèle de langage. Cela peut être utile pour obtenir des sorties cohérentes avec une entrée ou un contexte spécifique. La valeur seed peut être un nombre entier ou une chaîne de caractères.

- Min-P : Cette option définit un seuil de probabilité minimum pour les phrases générées. Les phrases dont la probabilité est inférieure au seuil Min-P seront ignorées. Cela peut être utile pour filtrer les sorties peu probables ou incohérentes. La valeur de Min-P est un nombre compris entre 0 et 1.

- PrPen : Cette option applique une pénalité de probabilité aux phrases répétées. Cela peut être utile pour encourager la diversité des sorties. La valeur de PrPen est un nombre positif. Des valeurs de PrPen plus élevées pénalisent davantage les phrases répétées.

- DyTmp : Cette option utilise une technique appelée "dynamic temperature sampling" pour générer des sorties. La température dynamique ajuste la température d'échantillonnage en fonction de la longueur de la sortie générée. Cela peut être utile pour obtenir des sorties plus cohérentes et grammaticalement correctes. La valeur de DyTmp est un nombre positif. Des valeurs de DyTmp plus élevées conduisent à des sorties plus cohérentes et grammaticalement correctes, mais moins variées.

Mirostat : les paramètres Tau et Eta jouent des rôles distincts mais complémentaires pour contrôler la qualité et la diversité des sorties :

- Tau : représente la perplexité cible que vous souhaitez pour le texte généré. La perplexité mesure la complexité et la surprise du texte. Une valeur de perplexité plus élevée indique un texte plus complexe et surprenant, tandis qu'une valeur inférieure indique un texte plus simple et prévisible.

- Eta : détermine la rapidité avec laquelle Mirostat ajuste la valeur de k en réponse aux changements de perplexité du texte généré.

Pour un texte plus original et surprenant, optez pour un Tau élevé et un Eta modéré. Pour un texte plus cohérent et grammaticalement correct, optez pour un Tau faible et un Eta élevé.

Additional Configs (Grammar Sampling) : permet de contrôler la structure (syntaxe) du texte généré. Garantit que le texte généré suit un format spécifique, ce qui est utile pour les cas où vous avez besoin de générer du code, des descriptions techniques ou un style d'écriture particulier. En limitant les options de l'IA, vous pouvez potentiellement réduire le nombre de phrases absurdes ou grammaticalement incorrectes.

L'échantillonnage grammatical vous permet de fournir un ensemble de règles écrites au format GBNF (Backus-Naur Form), un langage formel utilisé pour définir la grammaire d'une langue. Le format GBNF spécifie les manières valides de combiner des mots et des phrases pour former des phrases grammaticalement correctes. En fournissant des règles GBNF à l'IA, vous définissez essentiellement les structures de phrases autorisées pour le texte généré.

Token Streaming : fonctionnalité qui permet d'afficher les résultats de l'IA de manière progressive, améliorant l'expérience utilisateur et permettant un suivi plus interactif de la génération de texte.

Idle Responses : génère automatiquement de nouvelles réponses après quelques secondes d'inactivité du joueur.

Trim Sentences : permet de contrôler la longueur des réponses générées par l'IA. Permet d'obtenir des réponses plus courtes et plus directes de l'IA, en ne conservant que la dernière phrase complète.

Trim Whitespace : permet de nettoyer le texte que vous fournissez à l'IA, en supprimant les espaces superflus. Nettoie votre texte en supprimant les sauts de ligne et les espaces en fin de texte, ce qui peut améliorer la lisibilité et le traitement du texte par l'IA.

Compress Newlines : permet d'obtenir une sortie de l'IA plus condensée et plus facile à lire, en supprimant les sauts de ligne superflus.

EOS Token Ban : permet de gérer le moment où l'IA arrête de générer du texte, en fonction de vos besoins en matière de complétude et de longueur de réponse.

- Auto (automatique) : L'IA décide elle-même d'utiliser ou non le jeton EOS en fonction de sa perception de la complétude de la réponse.

- Unban (débloquer): L'IA est toujours autorisée à utiliser le jeton EOS. Elle peut donc arrêter sa réponse de manière anticipée si elle juge qu'elle est finie.

- Ban (interdire) : L'IA ne peut pas utiliser le jeton EOS. Elle continuera à générer du texte jusqu'à ce qu'on l'arrête explicitement ou qu'elle atteigne une limite de longueur prédéfinie.

Placeholder Tags : option permettant d'utiliser des balises spéciales dans la création de cartes de personnages ou de scénarios pour un chatbot. Ces balises seront ensuite remplacées dynamiquement par les valeurs appropriées au moment de l'exécution.

Balises disponibles :

- {{user}}: Sera remplacé par le nom d'utilisateur ou le pseudonyme choisi par la personne qui interagit avec le chatbot.

- {{char}}: Sera remplacé par le surnom spécifique du chatbot défini pour la conversation en cours.

- {{[INPUT]}}: Sera remplacé par le texte que l'utilisateur a saisi et envoyé au chatbot.

- {{[OUTPUT]}}: Sera remplacé par la réponse générée par le chatbot à l'utilisateur.

Render Sp.Tags : permet d'afficher les balises spéciales intégrées au texte par l'IA. Son activation est déconseillée pour une utilisation normale, car ces balises n'ont pas d'intérêt pour l'utilisateur final et peuvent nuire à la lisibilité du texte.

Run In Background : permet à Kobold Lite de rester actif et disponible même si vous n'êtes pas directement sur la fenêtre du navigateur.

Autosave Session : sauvegarde de votre travail.

Embed Settings File : enregistrer et de partager vos histoires avec tous les paramètres de configuration que vous avez définis.

Rename Save File : message d'avertissement qui vous invite à saisir un nouveau nom de fichier distinct pour éviter les conflits et la perte de données.

Show Advanced Load : vous permet d'accéder à des fonctionnalités d'importation sélective pour vos fichiers de sauvegarde JSON. Cela vous offre plus de contrôle sur le contenu que vous chargez dans votre logiciel.

Autoscroll Text : suivre la génération de texte en continu sans avoir à faire défiler la fenêtre manuellement.

Unlock Scroll Height : permet d'afficher du texte en continu et d'éviter les limitations de hauteur de la fenêtre. Cependant, cela peut également rendre la navigation dans le texte plus difficile.

Inverted Colors : inverse les couleurs dans le mode light.

Background Img : paramétrer une image d'arrière plan.

C/ Paramètres Context :

Memory : permet de fournir à l'IA des informations persistantes sur le contexte de vos interactions. Cela permet d'améliorer la cohérence et la personnalisation de ses réponses. Insère des informations au début de chaque requête envoyée à l'IA.

Exemple d'utilisation :

Imaginons que vous interagissez avec une IA pour un jeu de rôle se déroulant dans un univers médiéval fantastique. Vous pourriez définir dans la section "Mémoire" le fait que votre personnage est un magicien elfe nommé "Elrin" et qu'il voyage pour accomplir une quête spécifique. Ainsi, chaque fois que vous poserez une question ou donnerez une instruction à l'IA, elle commencera par se remémorer ces informations sur votre personnage et son contexte.

Author's Note : influence l'ambiance et le comportement de l'IA dans vos interactions. En plaçant des instructions ou des suggestions à la fin de votre texte, vous pouvez guider l'IA vers une réponse qui correspond mieux à vos intentions. Place les informations près de la fin du texte que vous fournissez à l'IA.

Exemples d'utilisation:

Vous pouvez utiliser la "Note de l'Auteur" pour : indiquer un changement soudain d'ambiance (par exemple, "Mais soudain, un silence glacial s'abattit sur la pièce..." pour créer du suspense). Suggérer une émotion particulière pour le personnage de l'IA (par exemple, "demanda-t-elle avec un air d'inquiétude" pour influencer le ton de sa réponse).

World info : agit comme une sorte de dictionnaire interne pour l'IA. Génère des informations contextuelles de votre univers narratif. En définissant des clés et du contenu, vous créez une base de connaissances interne pour l'IA, ce qui améliore la cohérence et la fidélité à votre monde fictif.

- WI Insert Location : définit l'emplacement exact où l'information contextuelle doit être insérée dans la prochaine requête envoyée à l'IA. Vous permet de contrôler la précision du placement de l'information fournie dans "world info". Before A/N : Insère le contenu au début de la requête. After memory : Insère le contenu à la fin de la requête.

- WI Search Depth : permet de contrôler le retour en arrière dans votre texte que l'IA explore pour trouver les clés "world info". Cela peut améliorer la pertinence et la clarté des informations contextuelles utilisées par l'IA.

Tokens :

Extra Stopping Sequences : indique à l'IA des séquences de texte spécifiques qui, si elles sont générées, doivent déclencher l'arrêt prématuré de la génération.

Imaginons que vous écrivez une histoire et que vous ne voulez pas que l'IA inclue de scènes violentes. Vous pouvez définir une séquence d'arrêt supplémentaire comme "coup de feu" ou "sanglant". Si l'IA génère l'une de ces séquences dans votre texte, elle arrêtera la génération, évitant ainsi un contenu indésirable.

Logit Biases : option avancée qui permet d'influencer la façon dont l'IA génère du texte en modifiant la probabilité d'apparition de certains mots.

L'IA génère du texte en attribuant une probabilité à chaque mot (ou jeton) de son vocabulaire. Plus la probabilité d'un mot est élevée, plus il est susceptible d'apparaître dans le texte généré.

Cette option vous permet de définir un "dictionnaire" contenant des identifiants de jetons (mots) et des valeurs associées. Ces valeurs agissent comme des biais qui modifient la probabilité d'apparition des jetons correspondants.

Token ID (identifiant de jeton) : code unique qui identifie chaque mot du vocabulaire de l'IA.

Bias value : Un nombre qui détermine l'ampleur de la modification de la probabilité.

Token Filter : permet de supprimer complètement du vocabulaire de l'IA tout jeton (mot) contenant une sous-chaîne spécifique que vous définissez.

Par exemple, si vous définissez la sous-chaîne "mort", l'IA supprimera de son vocabulaire tous les mots contenant cette chaîne, tels que "mort", "mortel", etc.

Peut être utile pour g énérer du texte adapté à un public plus jeune en supprimant des mots vulgaires ou violents, influencer le style du texte en supprimant des mots jugés indésirables ou encore adapter le vocabulaire à un contexte spécifique (par exemple, filtrage de termes médicaux pour une IA écrivant une histoire fantastique).

Regex Replace : cherche du texte pour le remplacer par un autre.

Imaginons que vous ayez un texte rempli de fautes de frappe où "et" est souvent écrit "est". Vous pouvez définir un motif regex et un remplacement par "et". L'IA appliquera alors ce remplacement à toutes les occurrences de "est" dans votre texte, le transformant en "et".

Placeholder Tags : permet de remplacer automatiquement des éléments spécifiques dans votre texte par d'autres contenus. Ces éléments sont appelés des "balises" (placeholders).

Vous définissez des paires "balise - contenu de remplacement". Lorsque l'IA rencontre une balise dans votre texte, elle la remplace automatiquement par le contenu associé que vous avez défini.

Exemple : imaginons que vous écrivez un document et que vous voulez insérer le nom de votre ville à plusieurs endroits. Vous pouvez définir une balise "[VILLE]" et un contenu de remplacement "Paris". Chaque fois que vous écrirez "[VILLE]" dans votre texte, l'IA le remplacera automatiquement par "Paris".

En résumé, les "Balises de remplacement automatique" vous permettent de gagner du temps et d'améliorer la cohérence de votre texte en automatisant l'insertion de contenus spécifiques à la place de balises définies.

maj le 10/06/24

Enregistrer un commentaire

Les commentaires sont validés manuellement avant publication. Il est normal que ceux-ci n'apparaissent pas immédiatement.